ChatGPTやClaudeを使ってて、「これ、最新情報じゃないな」とか「なんか間違ったこと言ってるぞ」って思ったこと、ありませんか?生成AIって便利なんですけど、知識が古かったり、時々嘘をついたりする問題があるんですよね。

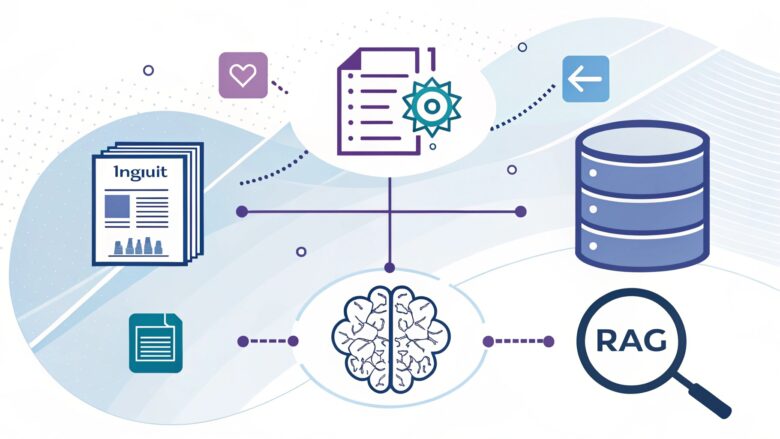

その解決策として今注目されてるのが「RAG(Retrieval-Augmented Generation)」、日本語で言うと「検索拡張生成」です。正直、名前だけ聞くと難しそうですけど、コンセプト自体はシンプルで、実はものすごく実用的なんです。

この記事では、RAGが何なのか、どういう仕組みで動くのか、そして実際にどうやって使うのか、できるだけわかりやすく解説していきます。

RAGとは?生成AIの弱点を補う技術

まず基本から。RAGっていうのは、簡単に言えば「AIに答えさせる前に、関連情報を検索して渡してあげる」技術です。例えるなら、カンニングペーパーを渡してテストを受けさせるようなもの。

通常のChatGPTは、学習済みの知識だけで答えを出そうとします。でもその知識は2023年とか2024年とか、ある時点で止まってるわけです。しかもすべての情報を覚えてるわけじゃない。だから「2025年の最新ニュース教えて」とか「うちの会社の内部資料について教えて」って聞かれても答えられないんですよね。

RAGはこの問題を解決します。ユーザーが質問したら、まず関連する資料を検索する。それをAIに渡して「この情報を元に答えてね」って指示する。そうすると、AIは正確で最新の情報をもとに回答できるわけです。

なぜRAGが必要なのか

RAGが重要視される理由は、主に3つあります。

1. ハルシネーション(幻覚)対策

生成AIの最大の問題点って、自信満々に嘘をつくことなんです。これ、業務で使う場合、めちゃくちゃ危険ですよね。RAGを使えば、AIは実際の資料に基づいて答えるので、でたらめを言う可能性がグッと減ります。

2. 最新情報への対応

モデルの学習データは定期的にしか更新されません。でもRAGなら、データベースを更新するだけで、常に最新情報で答えられます。ニュース、株価、天気、社内の最新プロジェクト情報なんかも対応できるわけです。

3. 専門知識・社内情報への対応

ChatGPTは一般的な知識は豊富ですけど、あなたの会社独自の情報なんて知りません。でもRAGで社内資料を検索できるようにすれば、社内専用のAIアシスタントが作れるんです。これ、実際に企業で導入が進んでます。

RAGの仕組み:3つのステップで理解する

RAGは大きく分けて3つのステップで動きます。ちょっと技術的になりますけど、図解しながら説明しますね。

ステップ1:ドキュメントの準備(インデックス作成)

まず最初に、検索対象となる資料を準備します。これがRAGの土台になる部分です。

具体的には以下のような作業をします:

a) ドキュメントの収集

PDF、Word文書、ウェブページ、データベースなど、様々な形式の資料を集めます。社内のナレッジベースとか、製品マニュアルとか、過去のメールとか。

b) テキストの分割(チャンク化)

長い文書をそのまま扱うのは効率が悪いので、適切なサイズに分割します。だいたい500〜1000文字くらいのチャンクに分けることが多いです。この「チャンクサイズ」の調整、実は結構重要で、後で詳しく説明します。

c) ベクトル化(Embedding)

ここが一番技術的な部分です。テキストを「ベクトル」という数値の配列に変換します。これによって、「意味的な類似性」を計算できるようになるんです。

例えば、「犬」と「猫」は、文字列としては全然違います。でもベクトル空間では近い位置に配置される。なぜなら、どちらも「ペット」とか「動物」という共通の文脈を持ってるから。これ、本当に面白い技術なんですよね。

d) ベクトルデータベースへの格納

作成したベクトルを専用のデータベースに保存します。Pinecone、Weaviate、Chromaなんかが有名です。これらは高速なベクトル検索に特化したデータベースで、何百万件のドキュメントからでも一瞬で関連情報を見つけられます。

ステップ2:クエリの検索(Retrieval)

ユーザーから質問が来たら、関連する情報を検索します。

a) クエリのベクトル化

ユーザーの質問も同じ方法でベクトルに変換します。「2023年の売上データは?」という質問が、数値の配列になるわけです。

b) 類似度検索

質問のベクトルと、データベース内の全ドキュメントのベクトルを比較します。「コサイン類似度」とか「ユークリッド距離」とか、数学的な手法で類似性を計算する。

正直、数式の詳細は知らなくても大丈夫です。要は「意味的に近いドキュメントを見つける」ってことです。

c) トップK件の取得

最も関連性の高い上位K件(通常は3〜5件)のドキュメントを取り出します。全部渡すと文脈が長くなりすぎるので、厳選するわけですね。

ステップ3:回答の生成(Generation)

最後に、検索した情報を使ってAIに回答を生成させます。

プロンプトの構築

検索したドキュメントとユーザーの質問を組み合わせて、AIに渡すプロンプトを作ります。だいたいこんな感じ:

以下の情報を参考に、ユーザーの質問に答えてください。

情報がない場合は「情報がありません」と答えてください。

【参考情報】

(検索して取得したドキュメントの内容)

【質問】

2023年の売上データは?このプロンプトをGPT-4とかClaudeに渡すと、参考情報に基づいた正確な回答が返ってくるわけです。

RAGの実装:実際にやってみよう

理論はわかった、じゃあ実際にどうやって実装するの?って話ですよね。いくつか選択肢があります。

選択肢1:LangChainを使う(Python)

一番人気なのがLangChainです。RAG機能が最初から組み込まれてて、比較的簡単に実装できます。

基本的な流れ:

- ドキュメントローダーでPDFやテキストファイルを読み込む

- テキストスプリッターでチャンクに分割

- Embeddingモデル(OpenAI Embeddingsなど)でベクトル化

- ベクトルストア(ChromaやFAISS)に保存

- RetrievalQAチェーンで検索と回答生成を実行

LangChainのドキュメントがかなり充実してるので、初めての人でも公式チュートリアルに従えば動くものが作れます。正直、最初は写経から始めるのが一番早いです。

選択肢2:LlamaIndexを使う(Python)

もう一つの人気フレームワークがLlamaIndex(旧GPT Index)です。こっちはRAGに特化してて、より細かいカスタマイズができます。

LlamaIndexの強みは、複雑なドキュメント構造にも対応できること。例えば、階層構造を持つドキュメントとか、グラフ構造のデータとか。高度なRAGシステムを作りたいなら、LlamaIndexの方が向いてます。

選択肢3:専用サービスを使う

自分で実装するのが大変なら、専用サービスもあります。

Perplexity AI

RAGを使った検索エンジンとして有名です。質問すると、ウェブを検索して最新情報をもとに回答してくれます。引用元も明示されるので、情報の信頼性を確認できる。これ、本当に便利で、私も調べ物するときはよく使ってます。

NotionAI、Glean

企業向けのRAGサービスです。Notionの全ページとか、Google Driveの全ファイルとかを検索対象にして、社内AIアシスタントを作れます。導入が簡単で、コーディング不要なのがメリット。

RAG実装で注意すべきポイント

実際にRAGシステムを作ってみると、いくつか難しいポイントがあります。私が実装してハマったところを共有しますね。

1. チャンクサイズの調整

ドキュメントをどのくらいのサイズに分割するか、これがめちゃくちゃ重要です。

小さすぎると、文脈が失われて意味がわからなくなります。例えば「この製品は」って文だけ取り出しても、何の製品かわかりませんよね。

大きすぎると、検索精度が落ちます。1000文字のチャンクの中に、関連する情報が1行だけしかなかったら、そのチャンク全体の類似度が下がっちゃう。

一般的には500〜1000文字くらいが推奨されてますけど、これは扱う文書の種類によって変わります。技術文書なら小さめ、物語なら大きめ、みたいな。試行錯誤が必要です。

2. Embeddingモデルの選択

テキストをベクトルに変換するモデルも、精度に大きく影響します。

人気なのは:

- OpenAI Embeddings:高精度で使いやすい。ただし有料

- sentence-transformers:オープンソースで無料。日本語にも対応

- Cohere Embeddings:多言語対応が強い

英語ならOpenAI、日本語なら日本語特化のモデル(例:intfloat/multilingual-e5-large)を使うのがおすすめです。ここケチると精度が全然違うので、投資する価値はあります。

3. メタデータの活用

ドキュメントにメタデータ(文書の種類、作成日、著者など)を付けておくと、検索精度が上がります。

例えば、「2023年の売上データは?」って質問されたとき、作成日が2023年のドキュメントを優先的に検索できる。こういう細かい工夫が、実用的なシステムを作る鍵なんですよね。

4. ハイブリッド検索の導入

ベクトル検索だけだと、固有名詞とか専門用語の検索が弱いことがあります。「TK-2000」みたいな製品番号とか。

そこで、従来のキーワード検索(BM25など)と組み合わせる「ハイブリッド検索」が推奨されてます。ベクトル検索で意味的類似性を、キーワード検索で完全一致を見つける。両方の結果を組み合わせると、精度がかなり上がります。

高度なRAG技術

基本的なRAGの仕組みは説明しましたけど、さらに進んだテクニックもあります。ちょっと上級者向けですが、興味がある人のために紹介しますね。

Reranking(再ランキング)

最初の検索で取得したドキュメントを、もう一度精密に評価し直す手法です。

具体的には、Cross-Encoderという別のモデルを使って、「この質問に対して、このドキュメントはどれくらい関連性があるか」を詳しく評価します。最初の粗い検索で候補を絞り込んで、Rerankingで精密に絞る。二段階検索みたいなイメージです。

これやると精度が10〜20%くらい上がるんですけど、処理時間も増えるので、トレードオフですね。

Query Expansion(クエリ拡張)

ユーザーの質問をそのまま検索するんじゃなくて、少し変形・拡張してから検索する手法です。

例えば「売上データは?」という質問を、「売上データ、売上高、売上実績、販売実績」みたいに複数の表現に展開する。これで検索の網を広げられます。

LLMを使って「この質問の言い換えを3つ作って」って頼むこともできます。ちょっと処理が重くなりますけど、検索漏れを防げる効果は大きいです。

Hypothetical Document Embeddings(HyDE)

これは面白い手法で、「質問に対する理想的な回答を先に生成して、その回答に似たドキュメントを探す」というアプローチです。

質問を直接ベクトル化するより、回答をベクトル化した方が、実際のドキュメントと類似性が高くなる、というアイデア。理論的には面白いんですけど、実装がちょっと複雑なので、まずは基本的なRAGをマスターしてからチャレンジするのがいいと思います。

RAGの実用例:こんなところで使われてる

理論ばっかりだと退屈なので、実際の活用例も紹介しますね。

1. カスタマーサポートの自動化

製品マニュアルやFAQをRAGシステムに読み込ませて、顧客からの問い合わせに自動回答するチャットボット。これ、かなり普及してます。

従来のルールベースのチャットボットと違って、自然な会話ができるし、複雑な質問にも対応できる。導入企業では、サポートコストが30〜50%削減されたって報告もあります。

2. 社内ナレッジベース

Google DriveやNotionに散らばってる社内資料を全部検索対象にして、「社内版ChatGPT」を作る企業が増えてます。

「経費精算のやり方は?」「新製品の仕様書どこ?」みたいな質問に、関連資料を引っ張ってきて答えてくれる。新入社員の教育とか、部門間の情報共有とかが劇的に楽になります。

3. 医療・法律分野での文書検索

膨大な論文や判例を扱う分野でも、RAGが活躍してます。

医者が「この症状に関する最新の研究は?」って聞いたら、関連論文を検索して要約してくれる。弁護士が「この案件に関連する判例は?」って聞いたら、類似の判例を探してくれる。専門家の作業効率が大幅に向上してるんです。

4. Perplexity AIの成功

RAGを使った検索エンジンとして、Perplexity AIが急成長してます。2025年の評価額は30億ドルを超えたとか。

何が良いかって、普通の検索エンジンみたいに結果をリストで返すんじゃなくて、情報を統合して自然な文章で答えてくれること。しかも引用元が明示されるから、信頼性も確認できる。これ、Google検索の使い方を変える可能性がありますよね。

RAGの課題と今後の展望

RAGは素晴らしい技術ですけど、完璧じゃありません。いくつか課題もあります。

レイテンシ(応答時間)の問題

検索してから回答を生成するので、どうしても時間がかかります。ユーザーが質問してから答えが返ってくるまで、3〜5秒くらい。リアルタイム会話としてはちょっと遅い。

対策としては、ベクトル検索を高速化したり、キャッシュを使ったり。あとは「検索中…」ってローディング表示を出して、ユーザーに待ってもらうUX設計も大事です。

コンテキストウィンドウの限界

LLMには、一度に処理できる文字数の上限があります。GPT-4で128Kトークン(約10万文字)とか。

検索結果が多すぎると、全部入りきらないんですよね。だからトップ3〜5件に絞るわけですけど、そうすると重要な情報が漏れる可能性もある。このバランスが難しい。

最近は、Claudeの200Kトークンとか、Geminiの100万トークンとか、どんどん拡張されてます。将来的には、もっと多くの情報を一度に処理できるようになるでしょう。

マルチホップ推論の弱さ

複数のドキュメントを横断して推論する「マルチホップ推論」が、まだ苦手です。

例えば「AさんとBさんの共通の知人は誰?」みたいな質問。Aさんの人間関係とBさんの人間関係、両方の文書を読んで、交差する人を見つける必要があります。単純なRAGだとこういう推論が難しい。

これに対する研究も進んでて、反復的に検索と推論を繰り返すアプローチとか、グラフデータベースと組み合わせるアプローチとかが提案されてます。

まとめ:RAGは生成AIの実用化に不可欠

長くなりましたけど、ここまで読んでいただきありがとうございます。最後にポイントをまとめますね。

RAGは、生成AIの弱点を補う重要な技術です。ハルシネーション対策、最新情報への対応、専門知識の活用、どれも企業でAIを実用化する上で必須の要素。

実装も、LangChainやLlamaIndexを使えば意外と簡単にできます。もちろん、チャンクサイズの調整とか、Embeddingモデルの選定とか、細かい最適化は必要ですけど。

個人的には、RAGは今後さらに重要になっていくと思います。生成AI単体では限界がある。でも外部知識を組み合わせることで、可能性が一気に広がる。PerplexityやNotionAIの成功が、それを証明してますよね。

これからAIシステムを作ろうと思ってる人は、RAGの理解は必須です。この記事が、その第一歩になれば嬉しいです。

次回は、実際にRAGシステムを実装してみた体験記をお届けする予定です。成功も失敗も、全部正直に書きますので、お楽しみに!

コメント